El pasado 9 de mayo, Javier Salas publicó en El País un artículo que describe de manera clara y precisa cómo funcionan los modelos de lenguaje, tomando como ejemplo una reciente anécdota en la que ChatGPT predecía quien iba a ser el próximo Papa en un programa en directo.

A continuación, destaco los puntos clave que considero más relevantes:

- Los modelos de lenguaje no adivinan ni profetizan; simplemente generan respuestas basadas en patrones previos de texto.

- El acierto de ChatGPT se debe a una combinación de factores:

- cómo se formuló la pregunta,

- qué datos recientes tenía el modelo,

- y su diseño probabilístico.

- Cambiar la formulación de la pregunta o, simplemente, por azar, puede dar como resultado una respuesta distinta. De hecho, distintas personas podrían obtener diferentes «predicciones».

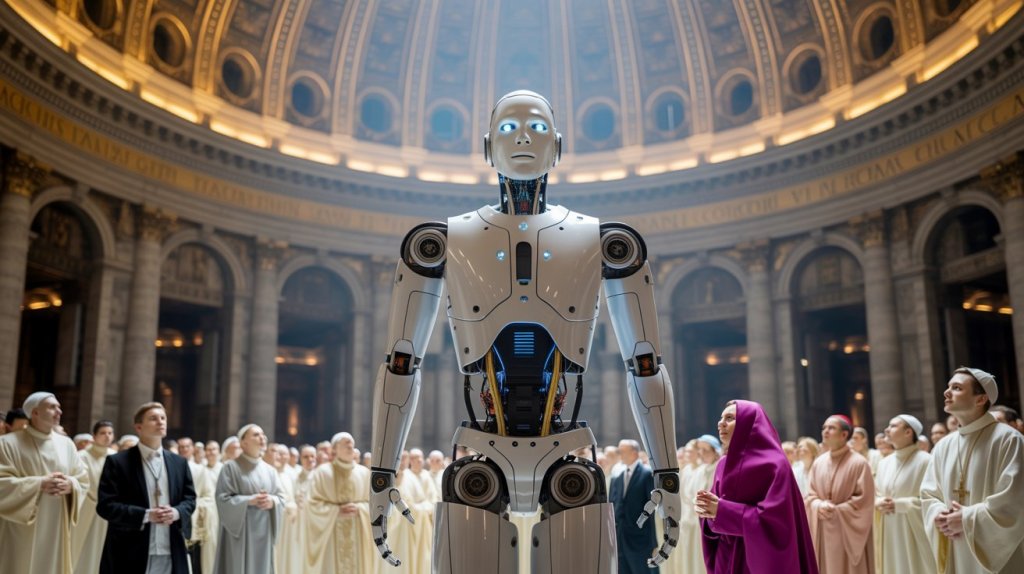

- Este episodio pone de manifiesto una tendencia preocupante: estamos atribuyendo a la inteligencia artificial capacidades «mágicas» que no posee. Pasamos de la «antropomorfización» a la «sacralización».

Ahora bien, creo que es importante matizar que el «acierto» en este caso no fue simplemente una predicción lanzada al azar. Prevost estaba entre los favoritos en las «quinielas», y ChatGPT recopiló esa información de internet para sintetizar una respuesta. Es decir, el modelo no lanzó una «predicción» sin base, sino que su respuesta se fundamentó en las predicciones y análisis previos.

Esto nos deja con una lección clave:

Los modelos de lenguaje, como ChatGPT, son herramientas extraordinarias para recuperar, agregar y sintetizar información. Esta capacidad, que antes parecía un sueño, está ahora al alcance de cualquiera por unos pocos euros o, incluso, gratis. En una sociedad y economía cada vez más centrada en la información, esta funcionalidad tiene un valor sin igual.

Lo que observo en los medios y en el debate público es que se cometen dos «pecados» simultáneamente. Por un lado, las posibilidades de la IA generativa (y esto también aplica a la IA en general) son sistemáticamente sobrevaloradas. Este fenómeno es claro en el artículo de Javier Salas, donde se evidencian las expectativas de que los modelos de lenguaje, como ChatGPT, puedan «predecir» el futuro o realizar tareas con una precisión casi mágica, cuando en realidad funcionan basados en patrones previos de información. Por otro lado, también se las infravalora de manera sistemática. Frente a quienes atribuyen propiedades «mágicas» a la IA, están aquellos que minimizan el impacto económico y social que tecnologías como ChatGPT pueden generar.

Mi consejo es que seamos cautos con los cambios que estamos viviendo. Aunque, a menudo, no sean tan espectaculares como se nos prometió, sí están teniendo un impacto real.